يمكننا تعريف إدارة الثقة والمخاطر والأمن في الذكاء الاصطناعي(Artificial Intelligence Trust, Risk, and Security Management/AI TRiSM) كإطار عمل شامل لضمان أن يتم استخدام تقنيات الذكاء الإصطناعي بطريقة آمنة وأخلاقية ومسؤولة. لقد غيرت ثورة الذكاء الإصطناعي العديد من جوانب حياتنا، من الاقتصاد إلى التكنولوجيا، رغم ذلك وكحال كل التقنيات الجديدة أتت معه تحديات ومخاطر غير مسبوقة. لذلك برزت الحاجة لهذا الإطار الذي يهدف إلى توجيه المؤسسات للعمل على تحديد وتخفيف المخاطر المتعلقة بموثوقية وأمن وثقة نماذج وتطبيقات الذكاء الاصطناعي. وضمان وجود حوكمة قوية لهذه الأنظمة، لا سيما فيما يتعلق بالأمن والخصوصية.

يهدف إطار العمل إلى أتمتة المهام المتكررة، وتعزيز القدرات التنبؤية للمشكلات المحتملة، وتمكين الحلول الاستباقية للعملاء. إن الهدف الرئيسي لـهذا الإطار يتجاوز مجرد تحسين الكفاءة التشغيلية؛ بل يهدف أيضًا إلى تعزيز رضا العملاء وبناء الثقة في تطبيقات الذكاء الاصطناعي عبر مختلف القطاعات.

ما أهمية(AI TRiSM) ؟

لقد أحدث الذكاء الاصطناعي ثورة في مختلف القطاعات، مما أدى إلى كفاءة لا مثيل لها، وأتمتة، وقدرات محسّنة لاتخاذ القرارات. ومع ذلك، فإن هذا التقدم التكنولوجي يأتي مع مجموعة من التحديات والمخاطر التي تحتاج المؤسسات إلى مواجهتها. فمع تزايد انتشار تقنيات الذكاء الاصطناعي، يقوم العديد من المستخدمين والمؤسسات بنشر هذه الأدوات دون فهم كامل للآليات الكامنة وراءها مما أحدث فجوة معرفية فيما يتعلق بكيفية عمل نماذج الذكاء الاصطناعي، والبيانات التي تستخدمها، وتحيزاتها المحتملة. هذا النقص يمكن أن يؤدي إلى تفسيرات خاطئة وعواقب غير مقصودة. وفي غياب إدارة المخاطر القوية، والمراقبة المستمرة، والضوابط الصارمة، قد تصبح نماذج الذكاء الاصطناعي غير موثوقة أو غير آمنة. هنا يبرز دور(AI TRiSM) كأداة حيوية، حيث يمكن للمؤسسات من خلاله تحسين نتائج تطبيقات الذكاء الاصطناعي، وضمان استخدام هذه التقنيات بأمان وأخلاقية.

ستة أسباب أساسية لدمج (AI TRiSM) في مشاريع الذكاء الاصطناعي :

يعد دمج AI TRiSM في نماذج الذكاء الاصطناعي أمرًا بالغ الأهمية، للأسباب التالية:

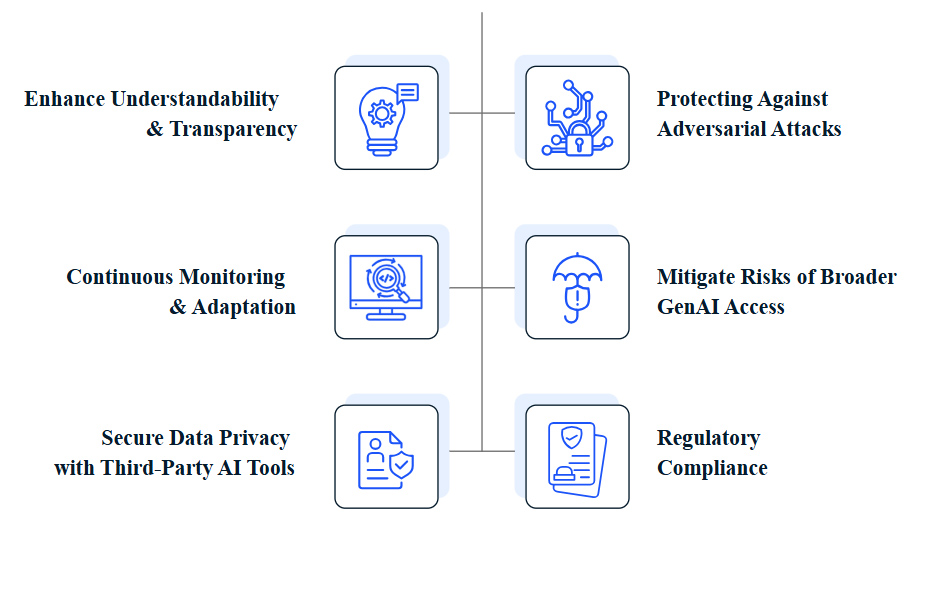

- تعزيز الفهم والشفافية: يوضح إطار العمل وظائف الذكاء الاصطناعي ونقاط قوته وضعفه، مما يتيح للمستخدمين فهم تعقيدات عملياته.

- مواجهة المخاطر من الوصول الواسع إلى الذكاء الاصطناعي التوليدي: يساعد إطار العمل في تخفيف المخاطر الناجمة عن أدوات مثل ChatGP، خاصة في البيئات السحابية.

- تأمين خصوصية البيانات باستخدام أدوات الذكاء الاصطناعي التابعة لجهات خارجية: يضمن أن ممارسات إدارة البيانات تتوافق مع معايير الخصوصية وتحمي من الانتهاكات.

- المراقبة المستمرة والتكيف: يتضمن إطار العمل إنشاء آليات مراقبة مستمرة للتأكد من أن نماذج الذكاء الاصطناعي تظل متوافقة وعادلة وأخلاقية.

- الحماية من الهجمات العدائية: يعالج إطار العمل التهديدات من خلال تطبيق تدابير أمنية متقدمة وبروتوكولات اختبار قوية.

- الامتثال التنظيمي: يضمن إطار العمل أن نماذج الذكاء الاصطناعي تتوافق مع اللوائح الحالية والمستقبلية، وتجنب العقوبات.

الأركان الأساسية لـ(AI TRiSM):

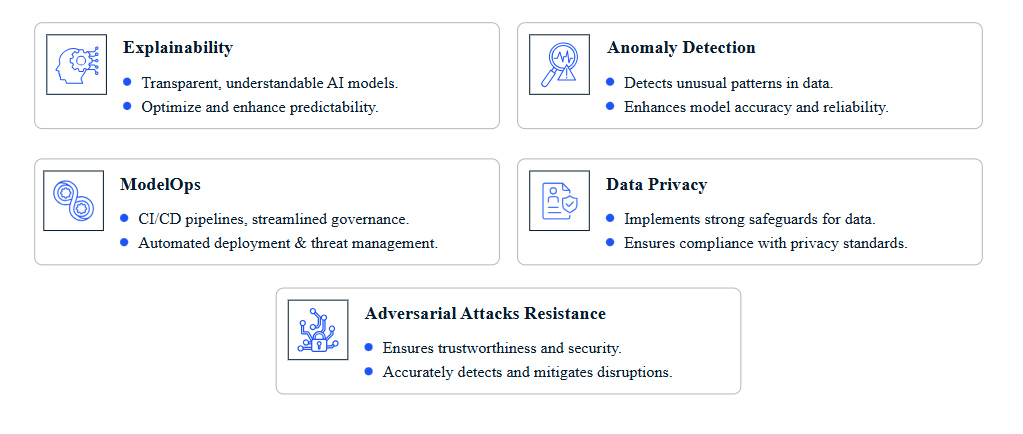

يستند AI TRiSM إلى خمسة أركان أساسية:

- القابلية للتفسير(Explainability): يضمن أن تكون أنظمة الذكاء الاصطناعي شفافة في عملياتها، مما يتيح فهم الآليات الداخلية لعمل نماذج التعلم الآلي.

- إدارة دورة حياة النماذج(ModelOps): هي إدارة دورة حياة نماذج الذكاء الاصطناعي، من التطوير إلى النشر والصيانة، مما يضمن تحديث الأنظمة وأدائها الأمثل.

- اكتشاف شذوذ البيانات(Data anomaly detection): يركز على تحديد وتصحيح التناقضات في البيانات التي قد تؤدي إلى نتائج غير دقيقة، مما يضمن الموثوقية في عمليات اتخاذ القرار.

- مقاومة الهجمات العدائية(Adversarial attack resistance): يحمي أنظمة الذكاء الاصطناعي من الهجمات التي تسعى إلى التلاعب بوظائفها، من خلال تنفيذ استراتيجيات متقدمة.

- حماية البيانات(Data protection): يضمن إدارة جميع البيانات المستخدمة من قبل أنظمة الذكاء الاصطناعي بشكل آمن وحمايتها من الوصول غير المصرح به.

حالات استخدام (AI TRiSM):

تعتبر أطر عمل(AI TRiSM) بالغة الأهمية للمؤسسات التي تنشر الذكاء الاصطناعي المؤسسي لإدارة وتخفيف المخاطر بشكل فعال. تتضمن المجالات الرئيسية التي يكون فيها إطار العمل ذا قيمة خاصة:

- الخدمات المالية(Financial Services): يمكن أن يساهم في اكتشاف الاحتيال (Fraud detection)، والامتثال التنظيمي.(Regulatory compliance)

- الرعاية الصحية(Healthcare): له دور رئيسي في إدارة بيانات المرضى (Patient data management)، ودقة التشخيص (Diagnostic accuracy).

- البيع بالتجزئة والتجارة الإلكترونية(Retail and E-commerce): يمكن استخدامه لتخصيص تجربة العملاء (Customer personalization)، وتحسين سلاسل التوريد (Supply chain optimization).

- المركبات ذاتية القيادة(Autonomous vehicles): يساهم في تعزيز السلامة والموثوقية (Safety and reliability)، وأمن البيانات (Data security).

- القطاع العام(Public sector): يمكن الاستفادة منه في حوكمة مبادرات المدن الذكية (Smart city initiatives)، وإنفاذ اللوائح(Regulatory enforcement).

- الأمن السيبراني(Cybersecurity): اكتشاف التهديدات والاستجابة لها .(Threat detection and response)

- التعليم(Education): يمكن أن يساهم في تطوير أنظمة التعلم التكيفي (Adaptive learning systems)، وخصوصية البيانات . (Data privacy)

اقرأ أيضا: 25 تقنية واعدة للعام 2025

تحديات (AI TRiSM):

تواجه المؤسسات العديد من التحديات عند تطبيق(AI TRiSM)، من بينها:

- مخاوف بشأن خصوصية البيانات وأمنها.

- الاعتبارات الأخلاقية والتحيز .

- الشفافية والخضوع للمساءلة الخوارزمية.

- التعامل مع نماذج اللغة الكبيرة المستضافة.

- الاعتماد المفرط على الذكاء الاصطناعي.

- تعقيد تهديدات الذكاء الاصطناعي.

- الامتثال التنظيمي .

- نقص الفهم وعدم كفاية المشاركة البشرية .

وللتغلب على هذه التحديات، يجب على المؤسسات:

- إنشاء حوكمة قوية للبيانات .

- تعزيز الشفافية والقابلية للتفسير .

- تحديد سياسات استخدام مقبولة ودقيقة .

- إجراء عمليات تدقيق منتظمة وتخفيف التحيز .

- الاعتماد على تصاميم ترتكز على الإنسان .

- الموازنة بين قابلية التفسير والدقة .

- تنفيذ أنظمة تصنيف البيانات ومنح الأذونات .

- الموازنة بين الذكاء الاصطناعي والإشراف البشري.

- الاستثمار في التدريب والبنية التحتية.

في ختام هذه الرحلة في عالم إدارة الثقة والمخاطر والأمن في الذكاء الاصطناعي، بدا واضحا أن دمج هذه الممارسات ليس مجرد خيار، بل هو ضرورة حتمية للمؤسسات التي تسعى إلى الاستفادة من قوة الذكاء الاصطناعي مع الحفاظ على أعلى معايير الأمن والأخلاق والمسؤولية. إنه الدرع الذي يحمي مستقبل التكنولوجيا، ويضمن أن تكون هذه الأدوات القوية في خدمة الإنسانية، وليس العكس. ومع استمرار تطور الذكاء الاصطناعي، سيزداد دور أطر إدارة الثقة والمخاطر والأمن في تشكيل مستقبل التكنولوجيا والمجتمع.

لا توجد تعليقات