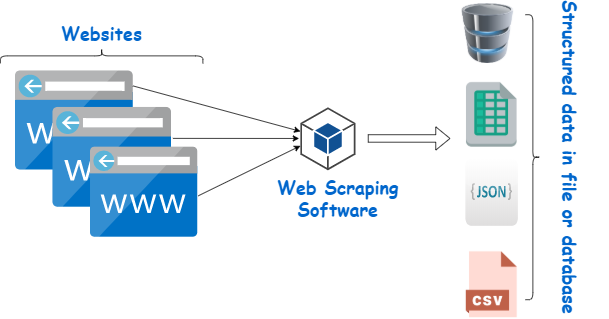

استخراج بيانات الويب(Web Scraping)، هي عملية آلية لجمع المعلومات من مواقع الإنترنت. يتم ذلك عن طريق استخدام برامج أو سكربتات تقوم بزيارة صفحات الويب، واستخراج المحتوى المطلوب، مثل النصوص، الصور، والبيانات المهيكلة. يمكن استخدام هذه البيانات لأغراض متعددة، بما في ذلك تحليل السوق، وأبحاث المنافسين، وتطوير التطبيقات. في هذا المقال، سنستكشف عالم استخراج بيانات الويب، من مفاهيمه الأساسية إلى تطبيقاته العملية وأفضل الممارسات والتحديات الأخلاقية والقانونية المرتبطة به.

لماذا استخراج بيانات الويب:

يمكن الاستفادة من هذه التقنية في مجالات متعددة، منها:

- جمع البيانات بكفاءة: يمكن لبرامج استخراج البيانات جمع كميات هائلة من المعلومات في وقت قصير، وهو ما قد يستغرق أياماً أو أسابيع إذا تم يدوياً.

- تحديث المعلومات: يمكن برمجة عمليات الاستخراج لتعمل بشكل دوري، مما يضمن الحصول على أحدث البيانات.

- أبحاث السوق: يمكن للشركات جمع معلومات عن المنافسين وأسعار المنتجات وآراء العملاء.

- تحليل البيانات: توفر البيانات المستخرجة مادة خام قيمة للتحليل واتخاذ القرارات المستندة إلى البيانات.

- أتمتة المهام: يمكن استخدام استخراج البيانات لأتمتة مهام جمع المعلومات المتكررة.

كيف يتم استخراج بيانات الويب؟

تتم عملية استخراج البيانات عادةً عبر عدة خطوات رئيسية:

- تحديد الهدف(Target Identification): تحديد الموقع أو المواقع التي تحتوي على البيانات المطلوبة.

- إرسال الطلب(Sending Request): إرسال طلب HTTP إلى الخادم (server) الذي يستضيف الموقع المستهدف.

- استلام الاستجابة(Receiving Response): استلام محتوى الصفحة، عادة بتنسيق HTML.

- تحليل المحتوى(Parsing): تحليل محتوى HTML لاستخراج البيانات المطلوبة. يتم هذا عادة باستخدام مكتبات مثل (BeautifulSoup) في بايثون أو (Cheerio) في Node.js.

- تنظيف البيانات(Data Cleaning): غالبًا ما تحتوي البيانات المستخرجة على معلومات غير ضرورية أو مكررة. لذا، يتم تنظيف البيانات للحصول على معلومات دقيقة وقابلة للاستخدام.

- تخزين البيانات(Data Storage): حفظ البيانات المستخرجة في قاعدة بيانات أو ملف.

الأدوات والتقنيات المستخدمة في استخراج بيانات الويب:

- لغات البرمجة: تعد بايثون(Python) من أكثر اللغات شيوعاً في استخراج البيانات، لكن يمكن أيضاً استخدام JavaScript وRuby وPHP وغيرها.

- مكتبات تحليل(HTML): مثل (BeautifulSoup) و (lxml) في بايثون، و(Cheerio) في .Node.js

- أطر العمل (Frameworks): مثل (Scrapy) في بايثون، الذي يوفر بنية كاملة لبناء برامج استخراج البيانات.

- أدوات محاكاة المتصفح(Headless Browsers): مثل (Selenium) و(Puppeteer)، والتي تسمح بالتفاعل مع صفحات الويب الديناميكية.

- خدمات استخراج البيانات السحابية: مثل(Octoparse)، والتي توفر واجهات سهلة الاستخدام لاستخراج البيانات دون الحاجة إلى برمجة.

تحديات وأخلاقيات استخراج بيانات الويب:

على الرغم من فوائده العديدة، يواجه استخراج بيانات الويب عدة تحديات وقضايا أخلاقية:

- القيود القانونية: قد يكون استخراج البيانات من بعض المواقع مخالفاً لشروط الاستخدام أو حتى للقوانين في بعض البلدان.

- حماية الخصوصية: يجب الحرص على عدم استخراج أو استخدام البيانات الشخصية بشكل غير قانوني.

- الضغط على الخوادم: قد تؤدي عمليات الاستخراج المكثفة إلى زيادة الحمل على خوادم الموقع المستهدف.

- التغييرات في هيكل الموقع: قد تؤدي التغييرات في تصميم أو هيكل الموقع المستهدف إلى تعطل برنامج الاستخراج.

- آليات الحماية: تستخدم بعض المواقع تقنيات مثل (CAPTCHA) أو حظر عناوين (IP) لمنع الاستخراج الآلي للبيانات.

اقرأ أيضا: الويب الدلالي، نحو فهم أعمق للمعلومات.

أفضل الممارسات في استخراج بيانات الويب:

هناك عدد من الممارسات التي يستحسن مراعاتها عن اجراء عملية استخراج بيانات الويب للحصول على أفضل النتائج وتجنب أي عوائق أو عراقيل:

- احترام ملف robots.txt: هذا الملف يحدد القواعد التي يجب على برامج الاستخراج اتباعها.

- التعريف الذاتي: استخدم رأس وكيل المستخدم (User-Agent header) لتعريف برنامجك للموقع المستهدف.

- التحكم في معدل الطلبات: تجنب إرسال عدد كبير من الطلبات في وقت قصير لتجنب الضغط على الخادم.

- التخزين المؤقت :(Caching)قم بتخزين البيانات المستخرجة مؤقتاً لتقليل عدد الطلبات المرسلة.

- استخدام واجهات برمجة التطبيقات :(APIs)إذا كان الموقع يوفر(API)، فمن الأفضل استخدامها بدلاً من استخراج البيانات مباشرة.

تطبيقات عملية لاستخراج بيانات الويب:

- مراقبة الأسعار: يمكن لأصحاب المتاجر الإلكترونية استخدام استخراج البيانات لمراقبة أسعار المنافسين.

- تجميع الأخبار: يمكن إنشاء مجمعات إخبارية تجمع المحتوى من مصادر متعددة.

- بحوث السوق: يمكن للشركات جمع آراء المستهلكين وتحليلها من مواقع التواصل الاجتماعي ومنتديات المناقشة.

- التوظيف: يمكن لشركات التوظيف جمع معلومات عن الوظائف المتاحة من مواقع التوظيف المختلفة.

- البحث العلمي: يمكن للباحثين جمع بيانات كبيرة لدراساتهم من مصادر متنوعة على الإنترنت.

مستقبل استخراج بيانات الويب:

مع تطور تقنيات الذكاء الاصطناعي (AI) وتعلم الآلة (Machine Learning)، من المتوقع أن تصبح عمليات استخراج البيانات أكثر ذكاءً وقدرة على التكيف. قد نرى في المستقبل:

- استخراج بيانات ذكي: برامج قادرة على فهم سياق البيانات وتكييف استراتيجيات الاستخراج تلقائياً.

- تحليل محتوى متقدم: القدرة على استخراج معلومات من الصور والفيديوهات بشكل أكثر فعالية.

- تكامل أعمق مع تحليلات البيانات الضخمة (Big Data Analytics): لاستخلاص رؤى أكثر عمقاً من البيانات المستخرجة.

- أطر عمل وأدوات أكثر تطوراً: لتسهيل عملية استخراج البيانات وجعلها في متناول المزيد من المستخدمين.

الخاتمة:

استخراج بيانات الويب هو تقنية قوية تفتح آفاقاً واسعة في عالم المعلومات الرقمية. مع القدرة على جمع وتحليل كميات هائلة من البيانات بسرعة وكفاءة، يمكن لهذه التقنية أن تقدم رؤى قيمة وتدعم اتخاذ القرارات في مجالات متنوعة. ومع ذلك، من المهم استخدام هذه التقنية بمسؤولية، مع مراعاة الاعتبارات الأخلاقية والقانونية.

مع تطور التكنولوجيا، سيستمر استخراج بيانات الويب في التطور، مقدماً فرصاً جديدة ومثيرة للشركات والباحثين والمطورين. سواء كنت مطوراً يسعى لبناء تطبيقات قائمة على البيانات، أو باحثاً يحتاج إلى جمع معلومات لدراسة، أو رائد أعمال يبحث عن رؤى السوق، فإن فهم وإتقان تقنيات استخراج بيانات الويب سيكون مهارة لا غنى عنها في المستقبل الرقمي.

لا توجد تعليقات